Arithmetische Folge und geometrische Reihe

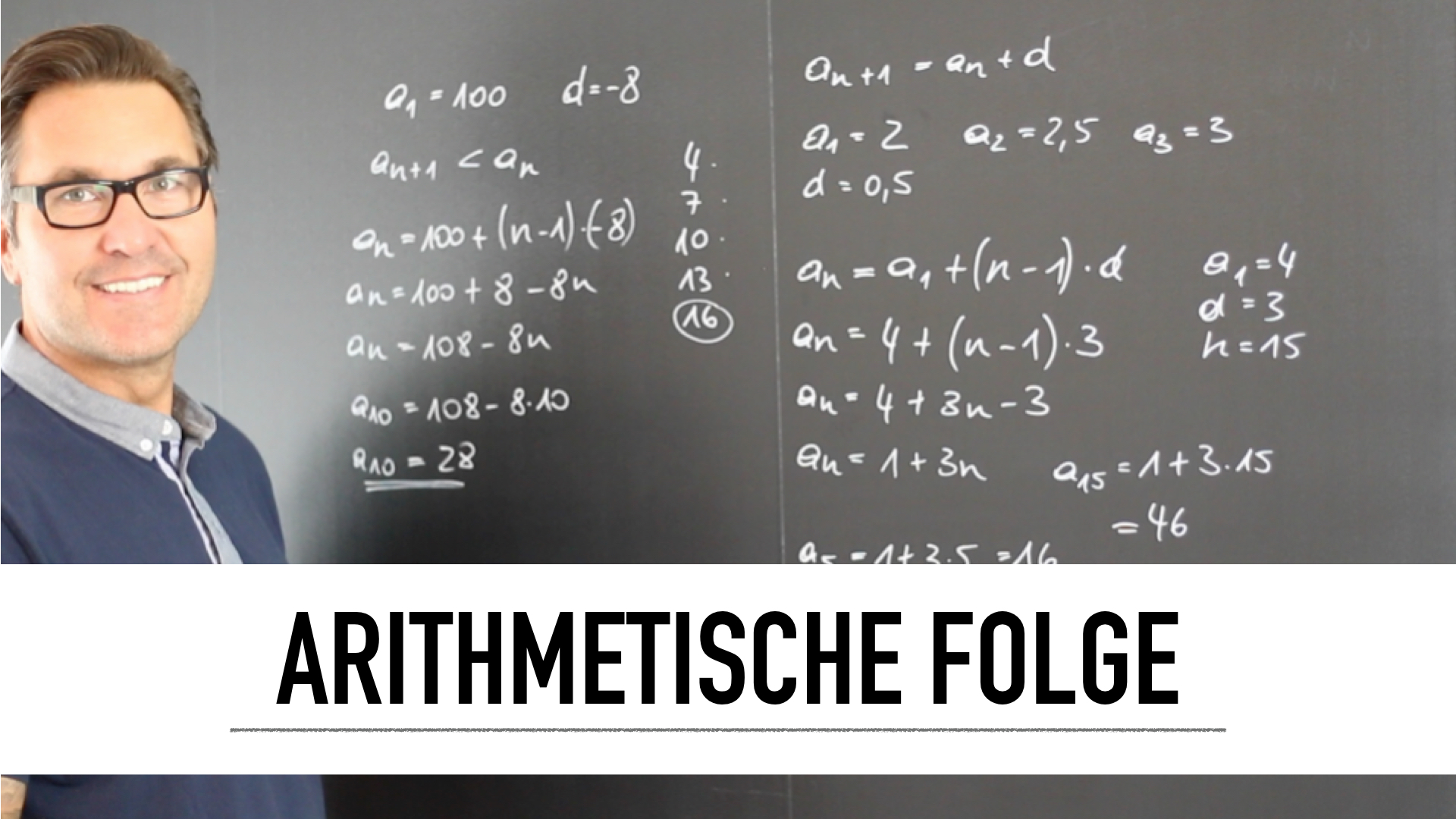

Eine arithmetische Folge (auch arithmetische Progression) ist eine regelmäßige mathematische Zahlenfolge mit der Eigenschaft, dass die Differenz zweier benachbarter Folgenglieder konstant ist. Eine einfache arithmetische Folge stellen die ungeraden natürlichen Zahlen dar: 1,3,5,7,9,…

Als Folge oder Sequenz wird in der Mathematik eine Auflistung (Familie) von endlich oder unendlich vielen fortlaufend nummerierten Objekten (beispielsweise Zahlen) bezeichnet. Dasselbe Objekt kann in einer Folge auch mehrfach auftreten.

Die zwei wichtigsten Folgen sind die arithmetische und die geometrische Folge. Sie treten in der Natur (radioaktiver Zerfall, bakterielles Wachstum), den Finanzwissenschaften (Zinsen und Zinseszinsen) und vielen weiteren Bereichen auf. Man sieht zudem, dass ein Wechsel zwischen expliziter und rekursiver Darstellung sehr einfach ist.

Was ist eine arithmetische Folge und eine geometrische Folge?

Du kannst erkennen, dass die Ähnlichkeit der zwei Definitionen nicht zufällig ist, die arithmetische Folge wächst additiv, die geometrische multiplikativ. Die geometrische Folge tritt in vielen Wachstums- und Zerfallsprozessen in der Natur auf, in der Zinsrechnung haben sowohl arithmetische als auch geometrische Folge ihren Platz.

Eine geometrische Folge ist eine regelmäßige mathematische Zahlenfolge mit der Eigenschaft, dass der Quotient zweier benachbarter Folgenglieder konstant ist.

Die Bezeichnung „geometrische Folge“ leitet sich aus dem geometrischen Mittel ab. Jedes Glied einer geometrischen Folge ist nämlich das geometrische Mittel seiner Nachbarglieder. Die Summierung der Folgenglieder ergibt die geometrische Reihe.

Eine geometrische Reihe ist die Reihe einer geometrischen Folge, deren n-tes Glied die Summe der ersten n Glieder der zugehörigen geometrischen Folge ist.

Wir unterscheiden zwischen endlichen und unendlichen Reihen, je nachdem, ob n endlich ist oder nicht. Eine unendliche geometrische Reihe entsteht, wenn bei der geometrischen Reihe n gegen unendlich geht.

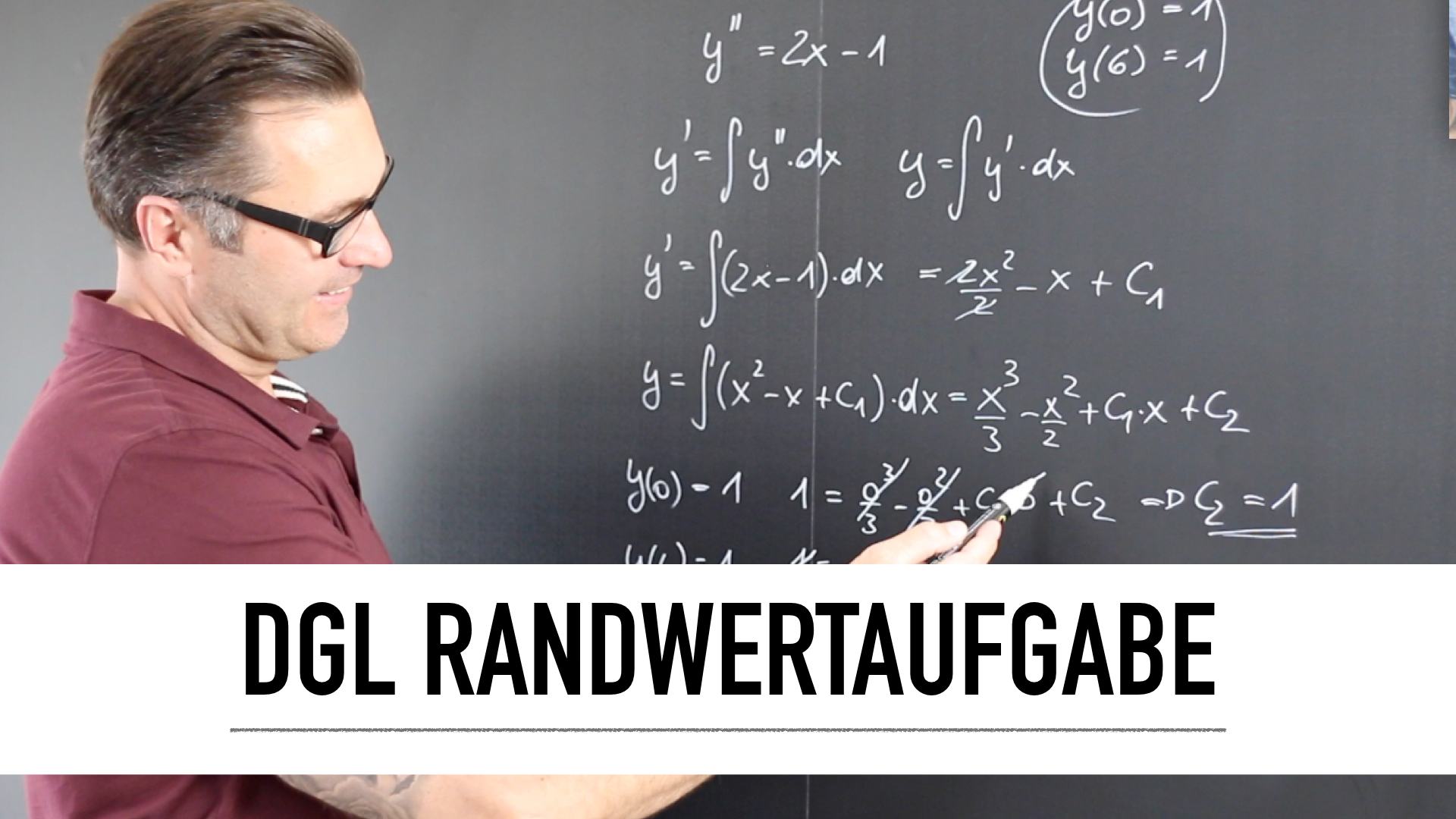

Arithmetische Reihen sind spezielle mathematische Reihen. Eine arithmetische Reihe ist die Folge, deren Glieder die Summe der ersten n Glieder (den Partialsummen) einer arithmetischen Folge sind. Arithmetische Reihen sind im Allgemeinen divergent. Es interessieren deshalb vor allem die Partialsummen, die auch als endliche arithmetische Reihen bezeichnet werden.

Es gibt eine einfache Formel zur Berechnung der Partialsummen beziehungsweise der endlichen arithmetischen Reihe. Die Summe einer endlichen arithmetischen Folge ist die Anzahl der Glieder multipliziert mit dem arithmetischen Mittel des ersten und des letzten Gliedes.